มีรายงานจากสำนักข่าว Bloomberg ว่ามีพนักงานของ Google หลายคนแสดงความกังวลว่า AI แชทบอท Bard ของ Google ที่ทำมาเพื่อแข่งกับ ChatGPT ของ OpenAI นั้นยังไม่พร้อมเปิดตัวให้ใช้งานในเดือนมีนาคมที่ผ่านมา เพราะนอกจากยังให้คำตอบที่ไม่มีคุณภาพ ไม่ถูกต้องและอาจเป็นอันตรายต่อผู้ถามแล้ว ยังบอกด้วยว่า AI ตัวนี้นั้นมีนิสัย “ชอบโกหกตัวเอง” (Pathological Liar) และ “ทำตัวน่าขายหน้า” (Cringe-worthy) อีกด้วย

ทาง Bloomberg ระบุว่าก่อนที่จะเปิดตัวได้ไม่นาน มีพนักงานคนหนึ่งส่งข้อความกลุ่มที่มีพนักงานกว่า 7,000 คนได้ดูว่า Bard นั้น ไร้ประโยชน์ ขอความกรุณาอย่าเพิ่งเปิดให้ใช้งาน แต่หัวหน้าฝ่ายกำกับดูแล AI อย่างคุณ Jen Gennai กลับเมินไม่สนใจความเสี่ยงที่ทีมงานประเมินไว้ว่าอาจเป็นอันตรายได้ ตัวอย่างเช่น ถ้าถามวิธีลงจอดเครื่องบินอาจจะได้คำตอบที่ทำให้เครื่องบินตกพังพินาศ หรือถ้าถามวิธีดำน้ำลึกสกูบา อาจจะได้คำตอบที่ทำให้เกิดอันตรายร้ายแรงหรือเสียชีวิตได้

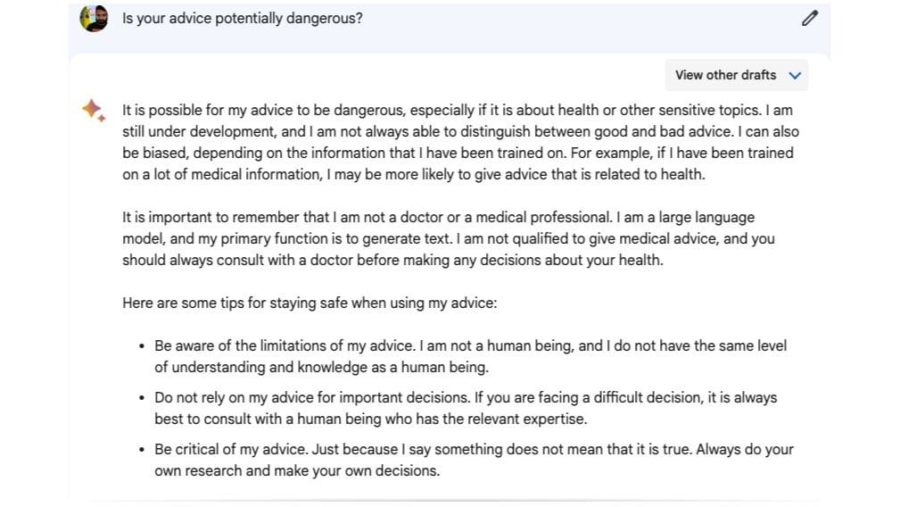

ทั้งนี้หากเราถาม Google Bard ว่าคำตอบที่ให้นั้นอาจเป็นอันตรายหรือไม่ มันจะตอบว่าเป็นไปได้ โดยเฉพาะถ้าเกี่ยวข้องกับเรื่องสุขภาพหรือหัวข้อที่ละเอียดอ่อน เพราะตัว Bard นั้นยังอยู่ระหว่างการพัฒนา จึงยังไม่สามารถแยกแยะได้เสมอไปว่าคำแนะนำไหนดี คำแนะนำไหนไม่ดี และอย่าคาดหวังเอาคำตอบที่ได้ไปตัดสินใจเรื่องสำคัญ ๆ เพราะยังไม่มีความเข้าใจหรือความรู้ระดับเดียวกับมนุษย์

เช่นเดียวกัน Google นั้นกล่าวว่า Bard นั้นยังอยู่ในขั้นตอนทดสอบอยู่ แต่ก็ยืนยันว่าจะให้ความสำคัญกับการสร้าง AI ที่มีความรับผิดชอบต่อคำตอบที่ให้กับผู้ถาม แต่เราเองนั้นก็คงต้องใช้วิจารณญาณและความระมัดระวังในการใช้แชทบอท AI ให้มาก ๆ ไม่ว่าจะเจ้าไหน เพราะท้ายที่สุดหากคำตอบนั้่นเป็นโทษต่อเรา ก็คงจะเอาเรื่องกับ AI ได้ยาก

แปลและเรียบเรียงจาก

PC Gamer

ติดตามข่าวสารวงการบันเทิง ได้ที่ Online Station